Token 是自然語言處理(NLP)中的一個基本概念,是文本的最小可處理單位。在如 Transformer 這種深度學習模型中,輸入的文本數據需要被轉換為 token 序列。模型通過學習這些 token 序列的模式和關系,來理解語言的結構和語義。

例如,在英文中,“Hello, world!” 可以被分解為以下 token:["Hello", ",", "world", "!"]。

在中文中,“你好,世界!”可以被分解為以下 token:["你好", ",", "世界", "!"]。

文本數據的Token分解

Token 可以做為訓練數據量的度量

業界通常會用 token 的數量來衡量訓練數據的規模。例如,DeepSeek v3 的預訓練使用了 14.8 萬億 token,這意味著模型在訓練過程中學習了 14.8 萬億個 token 的序列。

Token 可以做為計算復雜度的指標

模型的計算復雜度通常與 token 的數量密切相關,處理更多的 token 需要更多的計算資源和時間。

DeepSeek-R1 采用 Mixture-of-Experts (MoE) 架構,總參數量為 6710 億,每次推理時激活的參數為 370 億,模型使用了 14.8 萬億 tokens 進行訓練,最大生成長度為 32,768 tokens,支持長文本的處理。

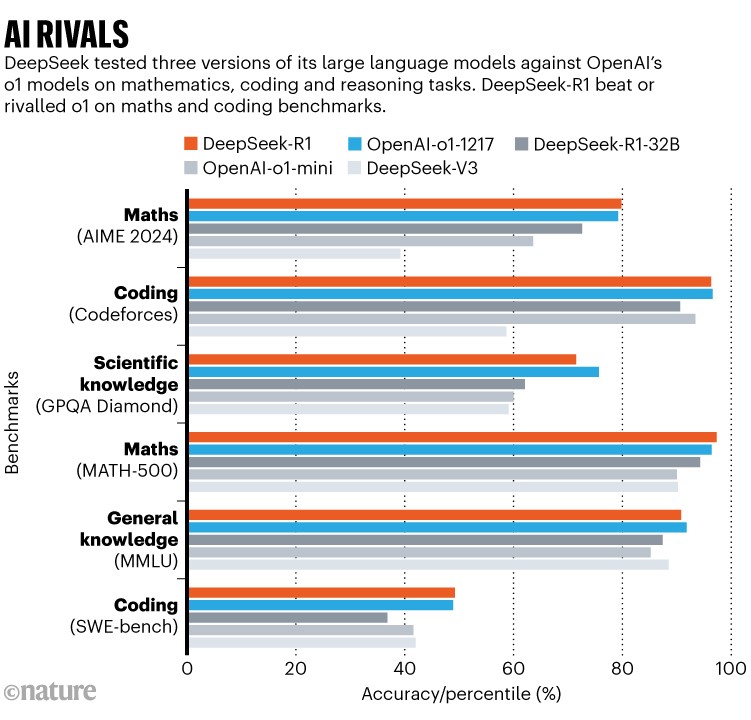

DeepSeek-R1的性能表現

在多個基準測試中,DeepSeek-R1 的性能與 OpenAI 的 o1 模型相當,甚至在某些任務上表現更優。

DeepSeek-R1在不同測試方式中的排名

DeepSeek-R1的運行成本

DeepSeek-R1 的運行成本顯著低于 OpenAI 的 o1 模型。具體來說,DeepSeek-R1 每百萬輸入token的成本為 0.55 美元,每百萬輸出token的成本為 2.19 美元,而 OpenAI o1 的成本分別為 15 美元和 60 美元。DeepSeek-R1 的成本降低了約 95%。

DeepSeek-R1的訓練成本

DeepSeek-R1 的預訓練階段使用了 2048 個 H800 GPU 的集群進行訓練,采用混合精度 FP8 訓練,耗時約 3.7 天,總計約 180,000 個 H800 小時。

DeepSeek-R1 的訓練成本約為 557 萬美元,在強化學習階段的計算成本估計約為 100 萬美元,總計約為600萬美元。相比較之下,Open AI o1 的訓練成本約為5億美元,成本是 DeepSeek-R1 的83倍。

算力需求趨于理性和均衡

DeepSeek 通過算法優化、數據效率提升、硬件利用率優化以及全流程成本控制等多方面的技術創新,顯著降低了訓練和推理所需的算力,實現了高性能模型的低成本訓練和部署。

以運行 DeepSeek R1 671B 全量模型所需硬件配置為例,具體如下:

CPU:AMD Ryzen 9 7950X 或更高配置。

內存:至少 1TB DDR5 內存。

存儲:至少 2TB PCIe 4.0 NVMe SSD。

顯卡:20張 RTX 3090 或 10張 RTX A6000。

雖然全量模型的運行的配置要求仍然比較高,但是對于企業用而言,不再是可望而不可及。

短期來看,算力需求的下降沖擊了傳統算力供應商的業務增長邏輯。長期來看,當AI應用百花齊放,大模型與產業應用深度結合之后,會推動算力需求持續上漲。

新興GPU和AI芯片廠商迎來發展機遇

DeepSeek 在研發過程中采用了PTX(Parallel Thread Execution)語言。PTX作為一種底層硬件指令集,能夠直接與GPU驅動函數進行交互,顯著降低了對CUDA框架的依賴,并在硬件適配方面展現出了更高的靈活性和自主性。

華為昇騰等國產GPU廠商已完成DeepSeek V3/R1的部署,并且開放服務。DeepSeek 的成功降低了大模型對高端芯片的依賴,為其他 AI 芯片廠商提供了更多的市場機會。

算法與芯片協同優化,推動邊緣AI加速應用

DeepSeek 模型的開源給了所有AI芯片廠商的創新提供了新思路,通過將芯片的CPU、GPU和TPU、FPGA等核心異構集成,針對AI模型算法進行進一步優化,可大幅提升端側AI設備的表現,從而推動AI的應用場景不斷拓展,從智能制造、智能駕駛、智能安防等領域向醫療、教育、金融、零售等更多行業滲透。